2024年のノーベル物理学賞は、ジョン・ホップフィールド氏(プリンストン大学、米国)、ジェフリー・ヒントン氏(トロント大学、カナダ)に授与された。現在のAIの基礎となる人工ニューラルネットワーク(神経回路網)による機械学習を可能にした発見と発明を評価したものだった。

しかし、同様の研究は日本でも行われていて、むしろ先行していた。その中心的な人物だった理化学研究所の甘利俊一さん(栄誉研究員/元脳科学総合研究センター長)は、このノーベル物理学賞の発表に対してコメントを発表。二人の受賞を祝福しつつ、「人工知能と神経回路網理論研究の源流は日本にもあり…」と添えていた。

前編の今回は、甘利さんに「源流」を振り返ってもらいながら、今のAIの技術につながる研究成果が日本でどのようにして生まれたのかを語っていただいた。

1960年代前半、若い研究者の自主サークルで理論を作った

―AIの研究の歴史を少し振り返りながら、甘利さんがいつごろから携わるようになったのかを教えていただけますか?

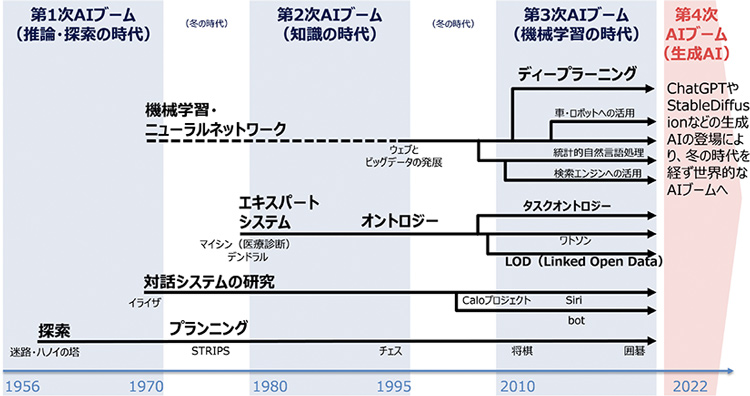

AIの研究そのものを振り返ると、現在に至るまでには何度もブームと下火の浮き沈みがありましたね。

最初のAIの研究は、コンピュータープログラムを組むことで知能を実現するというものでした。ただ、同じころ、人間の脳は学習によって知的な機能を得ていくのだから、コンピューターの中に人工の脳神経回路網を作って学習させれば、人間のような知的な機能を実現できるのではないかという考え方も出てきたんですね。

それが、心理学者のフランク・ローゼンブラット(米国)が提唱した脳型の学習機械「パーセプトロン」でした。1950~60年代の話ですね。結局のところ、今のAIもこのパーセプトロンの発展型です。

その研究の初期のころから、これは脳の研究と結びつけたほうがいいだろうという考えがありました。つまり、脳の仕組みを情報という観点から研究すると、人工的な知能についても新たに何かがわかるのではないかということです。

私が東京大学で博士課程を終えたのは1963年でした。その後、九州大学に勤めることになりました。専攻は数理工学でしたね。数理工学というのは、要するに数学的な発想で世の中の森羅万象の仕組みを調べれば、それらについて理論的な解明ができるという考えです。だから、対象は何でもいい。私もいろいろなことを対象に研究をしていました。

私が九州大学に赴任したときは、ちょうどローゼンブラットのパーセプトロンが注目されていた時期でした。コンピューターの中で神経回路網のようなものをプログラムして学習をさせればパターン認識がうまくいくはずだというアイデアに、私も強い興味を覚えました。

それで、数学を専門にしている若い研究者と一緒に「パーセプトロンを研究しよう」と、学際的な研究サークルを作ったんです。これが、私のAIに直接かかわる最初の研究でした。

中間層でも学習できる仕組みを考えた

―その自主的な研究サークルで生まれたのが、今回のノーベル物理学賞で評価された研究実績につながる「確率的勾配降下法」だったと思うのですが、簡単にご説明いただけますでしょうか。

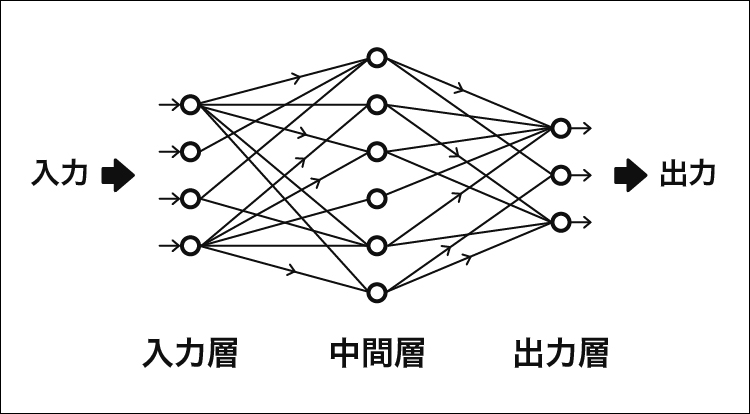

そうですね。ローゼンブラットが考えた学習機械のモデルは、入力信号を受ける「入力層」、情報を変換する「中間層」、最後に決定を下す「出力層」の3層で構成されています。学習は最後の層だけで行われ、中間層は情報の処理をするだけでした。

これに対して、私たちは中間層も学習するモデルを考えたんですね。では、機械が中間層でも学習できるようにするにはどうしたらいいのか。当時の人工ニューロン(脳の神経細胞をモデル化したもの)はオンになるかオフになるかのゼロイチ型で、答えを間違えたら出力層の素子に変更を加えて学習させるという仕組みだったんです。

しかし、私たちは「アナログニューロン」というものを考えて、1個のニューロンが「オン」の1か「オフ」の0になるというのではなくて、「3.61」とか「0.12」といった連続的に変化するアナログ量を受け取って出力できるようにすればいいんだと思いついたわけです。こうすれば、中間層でも学習できるようになって、機械学習がうまくできるようになるはずだと考えたんですね。本物の脳の神経細胞における入力や出力も、実はアナログなんです。

この仕組みを神経回路網のモデルに入れればいい。学習するときに答えを間違えたら、最後の出力層でも中間層でもいいので、結合するところで情報を受けるときのアナログ量を少し変える。そうすれば、最後の答えが少し変わる。たくさんのパラメーターを少しずつ変えて答えがどのように変わっていくかは、微分すればわかりますので、答えに近づくように変えていけば学習がどんどん進みます。これを数学的には「勾配」と言います。これを論文にまとめて世に出しました。1967年のことです。しかし、残念なことに、AIは無理だと世間の熱が冷めていき、70年代に入ると世界的にその研究が下火になってしまいました。

研究の源流は日本に「も」あった

―その後、1970年代の後半から1980年代にかけて第2次ブームがやってきますね。

そうですね。1986年、「バックプロパゲーション(誤差逆伝播法)」の論文が出ましたが、その機械学習の考え方は1967年の論文で示した僕らのアイデアとまったく同じでした。ただ、コンピューターの性能がかなり良くなっていましたので、コンピューターシミュレーションも大々的にできるようになって、これで第2次ブームが勢いづきました。ただ、僕らが作った理論はすっかり忘れ去られていたんですよね。

一方、日本ではその頃、脳科学と数理情報科学を結びつけて、脳を数理的に調べる研究を進めようという動きが活発になっていました。そして、東大の伊藤正男先生が中心になって、脳の研究グループを大掛かりに組織するプロジェクトが始まったんですね。その中には理論の研究者も入れるべきだというので、私も加わりました。

脳の仕組みを数理的に研究しようという流れは、1960、70年代を通じて日本では脈々と流れていたんです。私は東大に戻って、脳の神経回路の研究に本格的に取り組むようになっていました。今回のノーベル賞でも話題になった福島邦彦さんはNHK放送技術研究所(NHK技研)にいて、そこで脳の仕組みを研究していたんですね。

福島さんや私など数人の研究者が中心になって脳のモデルの研究に取り組みました。当時の日本はいろいろな神経回路のモデルを提案していて、おそらくこの分野では1番の先進国でした。AIにかかわるところでは、1970年代に「連想記憶」というモデルを考えました。脳はどのように物事を記憶して思い出しているのか。脳は連想するように関連の情報が浮かんでくるのではないかと考えて、連想記憶のモデルを作ってみて数理的に定式化しました。

面白いことに、この連想記憶と確率勾配降下法の2つが、今回のノーベル物理学賞に評価された業績につながっています。直接にはつながらないのですが、彼らが僕たちのアイデアを改めて発見して、それを進展させて、今日のAIの発展に至っています。

実は、ホップフィールドの論文を見ると、私の論文が引用されているんです。でも、直接的には関係のない論文が引用されています。私の連想記憶の論文が直接的に引用されていなくて、その後に書いた自己組織にかかわる論文が引用されていたんです。どういう間違いでそのような引用になったのかは知りません。ただ、そんなこともありましたね。

―ノーベル物理学賞についてのコメントで、甘利さんは「日本にも源流があって」と書かれていますね。これはどのような意味を込めていらっしゃるのでしょうか?

今回のノーベル物理学賞で評価された研究の源流の一つは確率的勾配降下法です。考えれば当たり前のやり方ではあるのだけれど、神経回路網のパーセプトロンの学習が確率降下法でできると最初に言ったのは私です。

ホップフィールドの連想記憶モデルも、先ほど話しましたが、すでに同じモデルが日本から出されていました。中間層を深く重ねて処理する深層学習(ディープラーニング)の仕組みも、福島さんが考えた「ネオコグニトロン」と基本的に同じで、これは1978年頃の日本ですでにやっていた研究です。

だから、「日本にも源流がある」と書いたんですね。ただ、あのメッセージの原稿を書いているとき、「も」を入れず、「日本に源流が」と書こうかなと少し迷いました。でも、それはやはり不遜かなと思ったんです。なぜなら、日本の研究の前には、ローゼンブラッドなどの巨人たちがいて、その影響を受けて僕らも研究をやってきたわけですからね。だから、「日本にも」という「も」を入れた表現が適切だろうと思ったんです。

関連リンク

- 理化学研究所「2024年ノーベル物理学賞について甘利 俊一 栄誉研究員・第二代脳科学総合研究センター長からのコメント」

- 理化学研究所 脳神経科学研究センター

- 理化学研究所 脳神経科学研究センターInstagram「2024年ノーベル物理学賞について、甘利 俊一 栄誉研究員・第二代脳科学総合研究センター長からのコメント」