かつて、日本では現在のAI技術につながる研究が行われていた。世界トップレベルを走るときもあったが、やがて米国の勢いにのまれてしまった…。最終回は前編に引き続き、理化学研究所の甘利俊一さんに日本の神経回路網など、AIにかかわる研究史を振り返りながら、米国と日本の違いについて語っていただいた。その上で、今の日本が挑めるAI研究は何かについて、甘利さんのお考えも尋ねた。

グーグルの助けを借りて開発された深層学習

―日米の違いは何だったのでしょうか?

1980年代から90年代にかけて第2次AIブームがあったのですが、「やはり実用にならない」と周りから言われるようになってしまい、再び下火になってしまいました。それでも、ジェフリー・ヒントン氏(トロント大学、カナダ)などの一部の研究者は粘り強く研究を続けました。

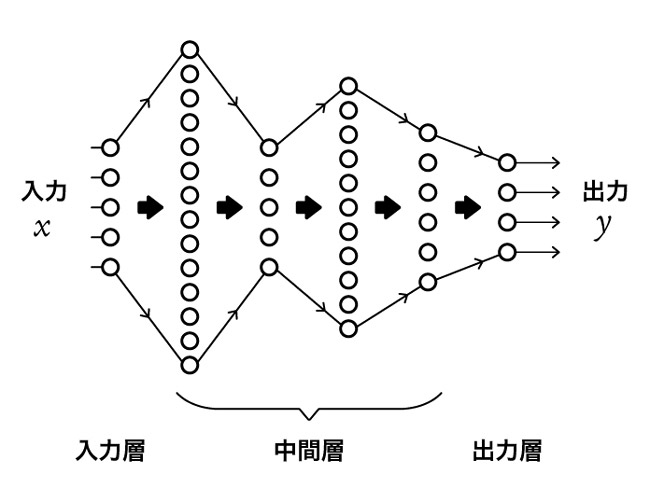

ヒントン氏もいろいろなアイデアを出していましたね。中でも卓越していたのは、脳型の学習機械「パーセプトロン」の中間層をもっと多層にしたら今まで以上のことができるのではないかという発想でした。深層学習です。2006年頃のことですね。

確かに、中間層を多層にすれば精度を上げられます。しかし、複雑になるのでプログラムを書くのがとても大変になります。でも、例題をいっぱい用意して、答えが合うように何度も計算させて学習させれば、書く手間を少なくできます。言い換えると、確率的勾配降下法で学習させればいいんです。ただ、これにしても、まともにやるとなかなか大変です。

そこでヒントン氏は工夫をさまざまに入れることによって、課題を乗り越えていきました。そして、グーグルの助けを借りてヒントン氏が開発した深層学習は、みんなが驚くほどの性能を発揮したんですね。それで一気に深層学習が盛り上がり、今に至ります。

日本は個人ベースの研究で取り残された

―そのとき、日本はどうしていたのですか?

手をこまねいて見ていたというか…。私は、コンピューターの中に人工の脳神経回路網を作り、脳の仕組みをモデル化する研究は面白くても、まさかそのモデルが実用になるなんて考えてもいなかったんです。NHK放送技術研究所や大阪大学などで研究していた福島邦彦さんは実用化しようと取り組んでいたようだけれど、多くの日本の研究者はそうは考えていなかったと思います。

日本の企業も、バブル経済のころはメーカーなどがAIの基礎研究にかなり力を入れていました。ひょっとしたらニューロコンピューターができるかもしれないという期待感もありましたよね。でも、バブルが崩壊すると、次々に手を引いてしまいました。

ヒントン氏ら少数の研究者が偉かったのは、AI研究ブームが去っても「これは実用になるはずだ」と頑張ったことです。その踏ん張りの中で、運よくグーグルが現れて、実用まで一気に進んだんです。

やはり、予算の額が日本と米国では大きく違います。ヒントン氏はグーグルと組んで、巨大な計算が可能でした。一方の日本は、どことなく個人ベースで研究を進めていたところがありました。結果的に、取り残された形になったんですね。

チャットGPTの優れた能力に驚嘆

―当時の勢いが米国のAI研究を今も支えているわけですね。

そうですね。そのAIの研究開発の動きはとても速く、その激流の中で登場したのが大規模言語モデル(LLM)でした。

言語というのは論理の塊です。中間層を調整していく神経回路網の理論では、言語モデルは実現できないだろうと思われていました。しかし、中間層を増やした深層学習で大規模に言語処理をするというやり方で、言語生成モデルを作り上げることができたんです。こうやって作りだされたLLMがいろいろなところで改良されていくと、人々の予想を超えてうまくいくようになって、今の社会的な大成功を収めたというわけです。

このような巨大な開発は、やはり日本ではなかなかできなかったでしょうね。大勢の優れた研究者の努力と、巨大なコンピューターと、ばく大な金と電力が注ぎ込まれたのだと思います。

私も、チャットGPTによく質問をするのですが、「どうしてこんなにうまく答えが出てくるの?」と感心します。うそをときどき言うので真に受けてはいけませんが、それにしてもなぜこんな優れた能力を発揮できるのか、驚嘆しないではいられません。

小規模化なら日本のメーカーのお家芸

―生成AIがどのように回答を生成するのか。その仕組みがまったくわかっていないということでしょうか?

あの仕組みは確かに人間が作りました。しかし、なぜあの巨大な生成AIのモデルがあれほどの機能を発揮するのか。それはまだ誰もわかっていないんです。思ったよりもうまくできてしまって、おそらく開発者もその性能の良さを知ったときに「こんなことができるなんて思ってもいなかった」とびっくりしたと思いますね。

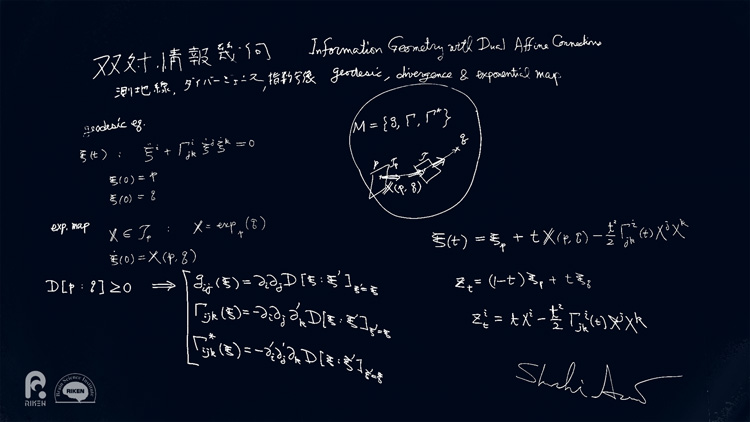

神経回路網があまりに巨大化したことで、何か新しい未知の性質がいっぱい出てくるようになったのかもしれません。その仕組みを解き明かす必要があります。

もう一つ言うと、今のAIはどこまでも巨大化していますが、実用にあたって求められるのは小規模のものです。つまり、ダウンサイジングがこれから求められます。小規模なもので性能の良いものを作るのは日本のメーカーのお家芸ですよ。小さくて優れたAIの開発を日本は積極的に取り組んでしかるべきだと思いますね。

理論に遅れ、新しい概念が求められる

―LLMは、入力してから回答を出すまでの過程がブラックボックスになっていると言われます。そのことを指摘されているのでしょうか?

いや、少し違います。入力層と出力層の間にある途中の中間層はブラックボックスではないんです。パラメーターはすべてわかっていて、どのような計算をしているかもわかっている。改めて計算させれば同じ結果も出てきます。でも、どうしてその計算をしたのか、その仕組みがわかっていないんです。

つまり、理論が遅れている。それが今の状況です。どうして、予想以上のものが生まれたのか。そこにはやはり何か原理があるはずです。これまでは理論があって、そこから「こういう仕組みを作ればこういうことができる」と取り組んできたのですが、それを大規模化していったら想像以上のものができてしまった。それで「なぜなんだ?」と。

新しい概念が必要なんです。それを導入して、このAIの仕組みの本質を見極めなければいけないし、それは我々人間ができるはずのものだと思うんですよね。

―そこが日本の挑むところではないかと?

理論の研究なら、お金があまりかかりません。日本ができることの一つは、そんな理論の研究で最先端を行くことです。巨大な装置が必要な研究は米国や中国に任せ、日本は一番基本となる原理のところを考える。研究費があまりなくても、工夫をすれば優れた研究はできます。かつて、経済成長をする前の日本でノーベル賞につながるAI研究ができたんです。

日本人だけが優秀だとは言いません。ただ、日本にも優秀な研究の芽があって、その芽を決して潰さないように育てていけば、これからいろいろなことができます。逆に、そうやっていかなければ、国際社会の中で生き残っていけないですよね。

関連リンク

- 理化学研究所「2024年ノーベル物理学賞について甘利 俊一 栄誉研究員・元脳科学総合研究センター長からのコメント」

- 理化学研究所 脳神経科学研究センター

- 理化学研究所 脳神経科学研究センターInstagram「2024年ノーベル物理学賞について、甘利 俊一 栄誉研究員・第二代脳科学総合研究センター長からのコメント」