AIの安全性(AIセーフティ)をめぐる国際的議論を日本がリードしようとしている。「AIセーフティ・インスティテュート(AISI)」は、生成AIの国際的なルールを検討する「広島AIプロセス」を機に昨年2月誕生した公的機関だ。国内においてAIの安全性確保の中心を担う一方、他国の機関とも連携しながら国際的なコンセンサスの構築を目指す。所長の村上明子さんは、多文化・多言語の観点でリスクに対応する姿勢を見せてくれた。

ガードレールのような存在

―AISIの国内における役割を教えてください。

まず申し上げたいのは、AISIは規制によってブレーキをかける機関ではないということです。規制をつくるのは国です。私たちは「規制から逸脱しない範囲で、どこまでアクセルを踏んで良いか」を示すガードレールのような存在ですね。

国には、AIによるイノベーションを国内で促進させたい狙いがあります。しかし、最新のリスクについて個別の企業等が網羅的に対応するのは容易でなく、コスト的にも見合いません。そこで、国が国際的な動向を見ながら適切にラインを示せば、結果的に企業の負担を減らすことができます。そのためにAISIは、国に対しては国内外のAIセーフティに関する最新動向などを、事業者に対しては国が示したレギュレーションを実装するのに必要な情報を提供します。

ただ、AIの進展が待ったなしの状況なので、AISIもガイドを作成し情報発信を始めています。企業が注意すべき点や、具体的な評価の観点も示しました。各方面から「ガイドがあって助かっています」といった反響もいただいています。

―村上さんは、AISIでどのような役割を期待されていると自認していますか。

おそらく、これまでのキャリアで培った経験を生かすことが求められていると思っています。

まず、海外のAISIなどと連携してAIセーフティを国際的に確保するには、学術的な視点が欠かせません。その点、私がもともと日本アイ・ビー・エムの研究者としてAI「ワトソン」の開発に携わったことは、研究者の考えを理解する上で役立つと思っています。実は、今のAI研究で中心的な役割を担っている方の多くは、私と同じ世代なんですよ。1990年代の「AI冬の時代」は人材が少なかったので、だいたい知り合いでして。このネットワークは、大いに活用していきたいと考えています。

また、今はAIを使う側にあたる民間企業に身を置いているので、日本の企業がAIビジネスを海外展開するときに、あるいは海外のAIを使って日本でビジネスをするときに、どこで困るのか、そして何に気を付けなければならないのか。そういった事情やニーズに明るい強みを生かし、AIセーフティに関わる情報を提供できればと考えています。

「品質」への意識に一日の長、国際的議論の中心担える

―国際的なAIセーフティの構築には他国との協調が必要ですが、議論をリードすることも重要ではないでしょうか。

国際連携の場で重要になるのは、中心的な存在になれるかどうかです。例えば規格づくりや標準化の場面において蚊帳の外に置かれてしまうと、日本にとって不利な内容を受け入れなくてはならなくなる可能性があります。議論の俎上に日本の考えをしっかりと載せていくことが重要です。

ただそのためには、日本が国際的な相互関係において貢献できる存在であることを示す必要があります。なかなか難しいのですが、「ここは日本に任せてください」と強く言えるような何かが必要だと思っています。

―具体的なアイデアはありますか。

個人的な考えですが、「品質」が一つのポイントになると思っています。現在、社会的にAIは導入段階であり、「まずは使ってみよう」という状況です。品質はそれほど問われていません。しかし、だんだんと品質への要求は高まっていくでしょう。

品質に対する意識が他国とは異なる日本は、製造業において一日の長があります。AIの開発や安全性においても、品質面で国際的な議論の中心を担うことが可能だと思っています。この点は、ぜひ製造業の方々にもご協力いただきたいところですし、AISIも技術的なガイドラインを提示したいと考えています。

例えば、企業が小規模言語モデル(SLM)のような小型で効率的なAIモデルを作るときには、インプットデータの品質が重要になります。こうした場面でAISIがガイドラインを示し、日本で作られるAIの品質や安全性が向上すれば、国際的に強みとして認識されやすくなるのではないかと思っています。

AIがもたらすリスクの多様化に懸念

―AIの研究開発が目覚ましく発展し、社会での普及も進む中で村上さんが懸念していることは何ですか。

AIがもたらすリスクの多様化ですね。AIが人間に近い存在になればなるほど、リスクが多様化します。

なぜなら基本的人権は文化等に依存するからです。例えば米国では、親しい間柄でない限り他人に年齢を尋ねてはいけないという暗黙のルールがあります。企業の採用面接で聞いてしまうと「年齢差別」と捉えられます。このように国によって法律やルール、規範、マナー、習慣はかなり異なりますし、自国で通用する振る舞いが他国では許されないことも多々あります。

このリスクはAIにも当てはまります。私が懸念しているのは、今のAIが英語圏の文化、特に米国の文化に強く依存していることです。偏った文化のもとで開発されたAIが、他の国では受け入れられないといったことも起きるでしょう。

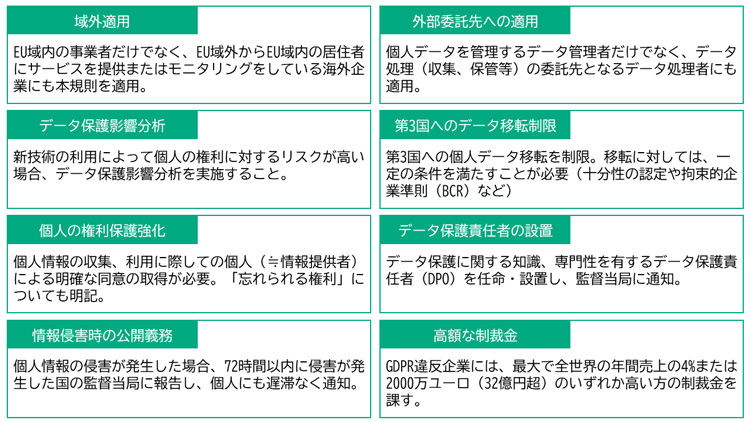

寡占状態へ対抗するために、欧州連合(EU)が域内の個人データの扱いを定めた「一般データ保護規則(GDPR)」は一定の障壁となりましたが、こうした規制は最先端のツールが使えないリスクとの表裏一体でもありました。

―日本だからこそ貢献できることはあるのでしょうか。

これまでAIには言語の依存性がないとされ、さまざまな国で使われることで発展してきました。しかし安全性に関しては、おそらく言語や文化の依存性がリスクとなるでしょう。私は、このリスクは決して小さなものではなく、非常に危うい面もあるのではないかと思っています。

英語の文化圏、特に米国で生まれ育つと、言語や文化の多様性の観点をどうしても持ちにくくなると感じています。限られた価値観の持ち主によって作られたAIのリスクについて、他の文化圏にいる私が話をすると、英語圏の方からは「気が付かなかった」といった反応が返ってくることも少なくありません。

その点、日本の非英語圏文化は強みになると思います。今後、「AIのリスクを多文化・多言語の観点でしっかり見よう」と日本から声を上げられたら良いですよね。それができれば、世界中のAI技術者やAI事業者にとって日本で活動するメリットにつながり得ると思っています。

前向きにAIと共生していくことが明るい未来を作る

―AIが詳らかにするさまざまな情報・事実は、格差拡大につながるとも指摘されます。例えば保険料の算出は、それが反映されやすいように感じます。

頭を悩ませている問題の一つで、私がAISIのほかに身を置く保険業界でも盛んに議論が行われています。例えば、AIを使って遺伝性疾患への罹患率を高精度で予測することなどは、技術的には可能になるでしょう。しかし、それを保険料の算出に活用して良いかどうかは全く別の問題で、個人情報保護やデータ利用の観点からも難しい問題だと思っていますし、私個人は反対の立場です。AIの技術発展とともに、どのように対処していくかを検討していくべき課題ですね。

―歯止めをかけるために必要な考え方は。

AIだけがやってはいけないことって、特にないと思うんですよね。AIに認められないことは、基本的に人間もやってはいけないことです。シンプルですが、そんな考え方が大事なのではないでしょうか。

―AIユーザー側の安全性については、どうお考えですか。

安全とは別に「安心」という側面についても考える必要があります。安心を得るには何が必要なのか。最後は「透明性」に行き着くと思っています。

多くの人は、自分のデータが知らないところで使われるかもしれないことに不安を持っていますよね。だからこそ事業者は、「顔認証で撮られた画像はAIの中だけで処理されます」などとユーザー側に明示しなければなりません。サービスやコンテンツを利用するときも、「これはAIを利用して作ったものです」と知らされれば、安心を覚えやすくなります。

―逆にユーザー側に求められることはありますか。

一番のリスクは、さまざまなリスクを恐れるあまり「AIを使わないこと」です。ただ、思考停止に陥って、リスクについて考えなくなるのもいけません。AIを教科書のように信じ切ってしまうと、行動や思考が同一化してしまいます。

AIに使われない人間になるために重要なのは、AIの仕組みやリスクを正しく知ろうとすることです。そして何を許容できるのか、一人一人が考えなければなりません。知ることから安全と安心が生まれ、AIを使いこなす力も身に付くのです。

人もAIも完璧な存在ではありません。AIが人間の仕事を全て代替してくれることはないので、人間が決めなくてはならないこと、やらなければいけないことは必ず残るでしょう。それでも前向きにAIと共生していくことが、私たちの明るい未来を作ってくれると信じています。

関連リンク

- AIセーフティ・インスティテュート

- 情報処理推進機構(IPA)プレス発表「プレス発表 AIセーフティ・インスティテュートを設立」

- 総務省「広島AIプロセス」